Il seguente è un testo che riassume i principali punti contenuti all'interno di un articolo di: theregister.com (link).

I punti sono stati generati inizialmente tramite intelligenza artificiale e poi revisionati e corretti a mano. L'obiettivo è quello di dare una panoramica più chiara anche ai lettori che non conoscono bene la lingua inglese o che vogliono una lettura svelta.

Articolo originale: https://www.theregister.com/2024/04/30/kill_killer_robots_now/

Concetti chiave

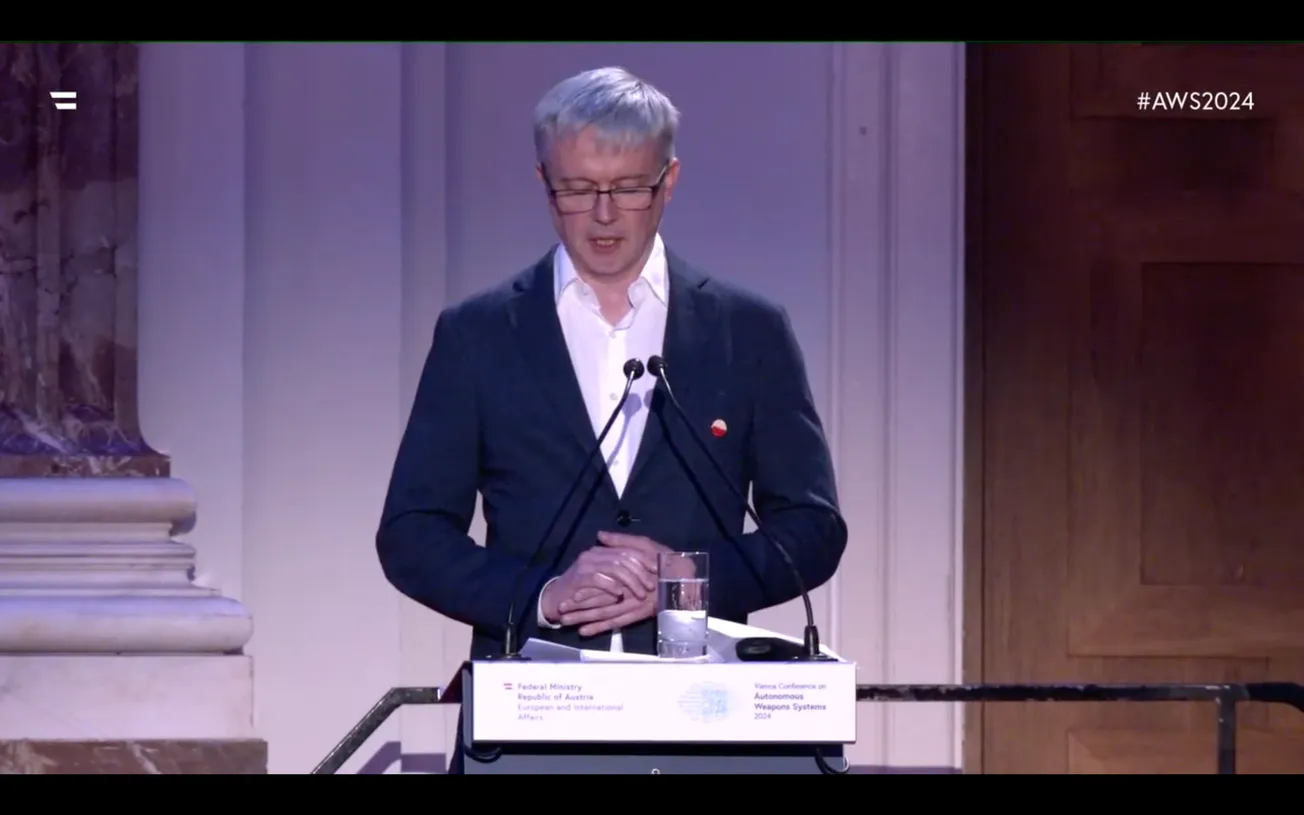

- Il "momento Oppenheimer": il ministro degli esteri austriaco, Alexander Schallenberg, ha sottolineato che l'ascesa dell'intelligenza artificiale militare rappresenta "il momento Oppenheimer della nostra generazione," e invoca una regolamentazione immediata sui "robot assassini" per garantire il controllo umano sulle decisioni letali.

- Armi autonome in guerra: Schallenberg ha evidenziato che "i sistemi d'armi autonomi riempiranno presto i campi di battaglia mondiali," mettendo in risalto droni dotati di intelligenza artificiale e sistemi di selezione dei bersagli basati sull'IA come esempi già in uso.

- L'IA nel militare oggi: Le preoccupazioni di Schallenberg sono fondate sugli sviluppi recenti, come le iniziative dell'Air Force statunitense e della DARPA riguardanti il controllo dell'IA su carri armati e un caccia F-16.

- Urgenza di norme internazionali: Il ministro ha sottolineato l'urgenza di "raggiungere un accordo su regole e norme internazionali per garantire il controllo umano," sottolineando che la decisione fondamentale su "chi vive e chi muore" deve rimanere nelle mani dell'uomo, non delle macchine.

- Usi positivi dell'IA: Pur evidenziando i pericoli dell'IA militare, Schallenberg ne ha riconosciuto i benefici. Hasan Mahmud, ministro degli esteri del Bangladesh, ha aggiunto che l'IA ha "un potenziale enorme per avanzare la scienza e aiutare l'umanità."

- Diritto internazionale: Mirjana Spoljaric Egger, presidente del Comitato Internazionale della Croce Rossa, ha espresso preoccupazione per il rispetto delle leggi internazionali in guerra in assenza di controllo umano sulle armi IA. Schallenberg ha evidenziato ciò chiedendosi chi sarebbe responsabile se qualcosa andasse storto - "Il comandante? L'operatore? Lo sviluppatore del software?"

- Allarme terrorismo: Schallenberg ha avvertito che le armi IA, a differenza delle armi nucleari, possono essere sviluppate con meno risorse e potrebbero "finire molto rapidamente nelle mani di attori non governativi o gruppi terroristici."

- Genocidi etnici: Il programmatore estone Jaan Tallinn ha avvertito che l'IA potrebbe evolversi per distinguere gli esseri umani in base all'etnia, rendendo "significativamente più facile effettuare genocidi e targetizzare gli omicidi che cercano specifiche caratteristiche umane."

- Rischio di conflitti: Tallinn ha sottolineato che l'IA rappresenta un considerevole rischio per l'umanità a causa di errori accidentali nelle armi autonome che potrebbero portare a conflitti più ampi.

- Ottimismo per la regolamentazione: I panelisti hanno espresso cauto ottimismo sulla regolamentazione delle armi IA, con Tallinn che ha sottolineato che l'umanità è riuscita in passato a vietare preventivamente altre tecnologie pericolose.