Il prompt design (l’arte di ottenere buoni risultati dalle AI grazie a richieste fatte bene), ad oggi, si è basato su due concetti chiave. La chiarezza della richiesta e la capacità di fornire al modello il “tempo di pensare” al compito assegnatogli. Ma mentre prima il secondo step doveva necessariamente essere creato artificialmente, grazie ad un prompt ben strutturato, con l’avvento del nuovo modello di OpenAI, Chatgpt o1 (nome in codice “Strawberry”), si inaugura l’era del ragionamento integrato.

Tre concetti che vi aiuteranno a navigare nelle novità in atto

- Chain-of-tought: la catena di pensieri.

Non è altro che la capacità di dividere un compito complesso in passaggi sempre più piccoli, fino a scomporlo ai minimi termini. Prima era necessario includerla con uno o più prompt. Adesso il modello, grazie al training che ha ricevuto con i feedback umani, è in grado di farlo in autonomia, migliorando notevolmente le risposte. Ricordate tutte quelle volte in cui avete dovuto scrivere in una conversazione con ChatGPT: “ok, ora però ricordati quello che ti avevo detto all’inizio”? Ora il modello lo fa da solo. - Reinforcement learning: l’apprendimento per rinforzo.

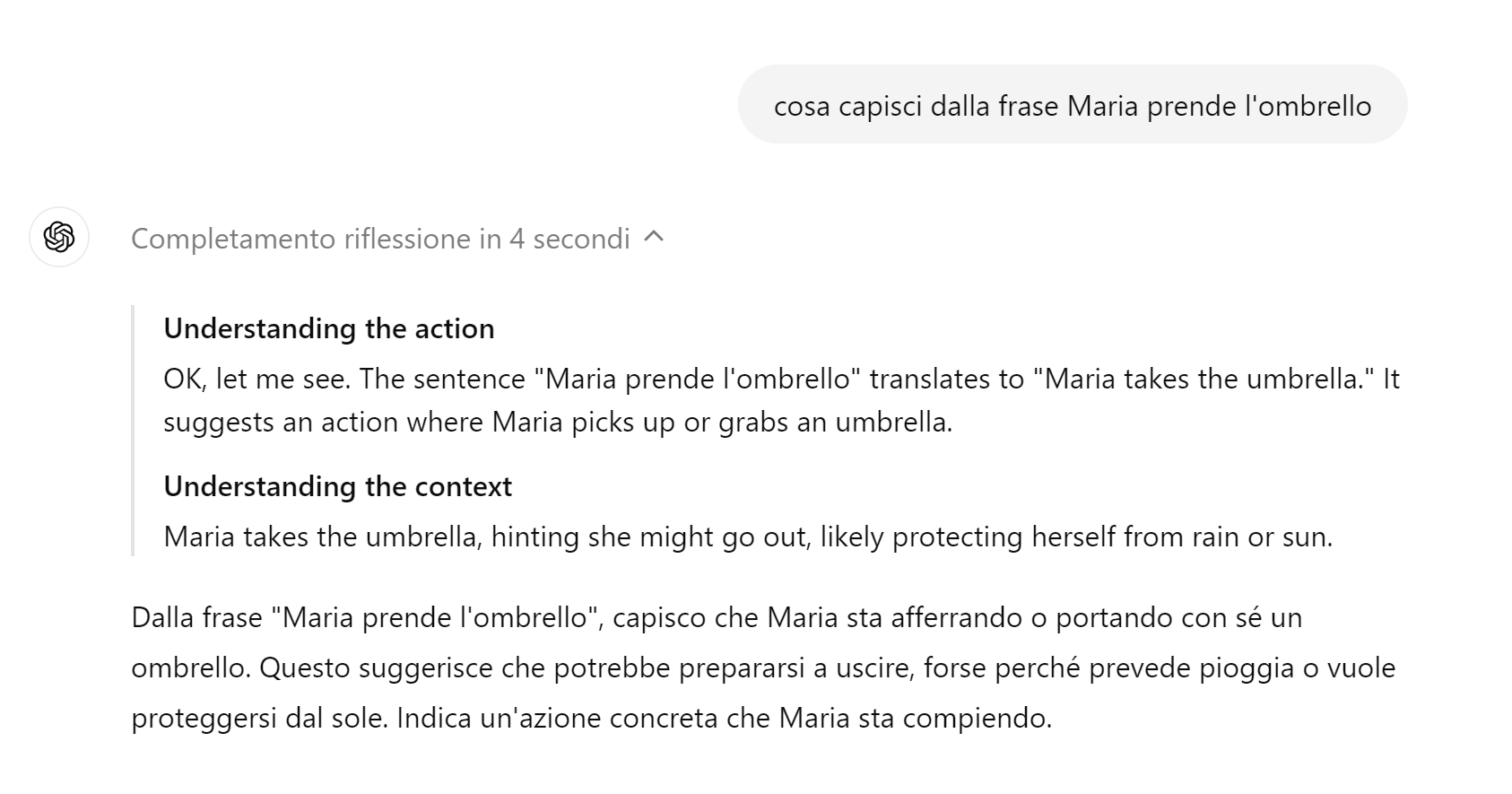

Il modello in fase di training riceve moltissimi feedback umani sulle sue risposte, li integra nel processo, ricomincia. Così “capisce” molto meglio come deve rispondere. Non confondiamoci però: quando chattiamo con ChatGPT non stiamo addestrando il modello, non è un apprendimento continuo ma un addestramento che viene svolto prima che il modello arrivi al grande pubblico. - Inferenza: è la capacità dei large language model come ChatGPT di leggere oltre la lettera del testo e di trarne del significato ulteriore.

Ad esempio, comprendere che se “Maria prende l’ombrello” vuol dire che sta per uscire e forse sta per piovere. Maggiore la capacità di inferenza, maggiore la possibilità che un LLM colga relazioni che potrebbero sfuggire al ragionamento umano.

Niente allegati, niente multimodalità

Se avete un abbonamento a ChatGPT, potete già sperimentare o1 in prima persona (per 30 richieste a settimana con o1-preview e 50 con o1-mini, poi dovrete tornare al modello 4). A differenza dei modelli precedenti non è ancora possibile allegare file né accedere a internet (la conoscenza dell’o1 è ferma all’ottobre 2023, in pratica non sa nemmeno di esistere), il che rende qualsiasi test sulla comprensione di ulteriore contesto prematuro. Non è inoltre multimodale, capisce solo altro testo.

Quest’epoca ci ha abituato a presentazioni roboanti ma a realtà meno entusiasmanti (pensate alle figuracce di Google, ma anche alle novità di OpenAI che ancora non vediamo come i miglioramenti dell’interfaccia vocale o la possibilità di generare video con Sora).

Tuttavia, possiamo ben sperare: se ci affidiamo a qualche piccolo quesito e ci fidiamo dei video dimostrativi di OpenAI, i passi avanti sono concreti.

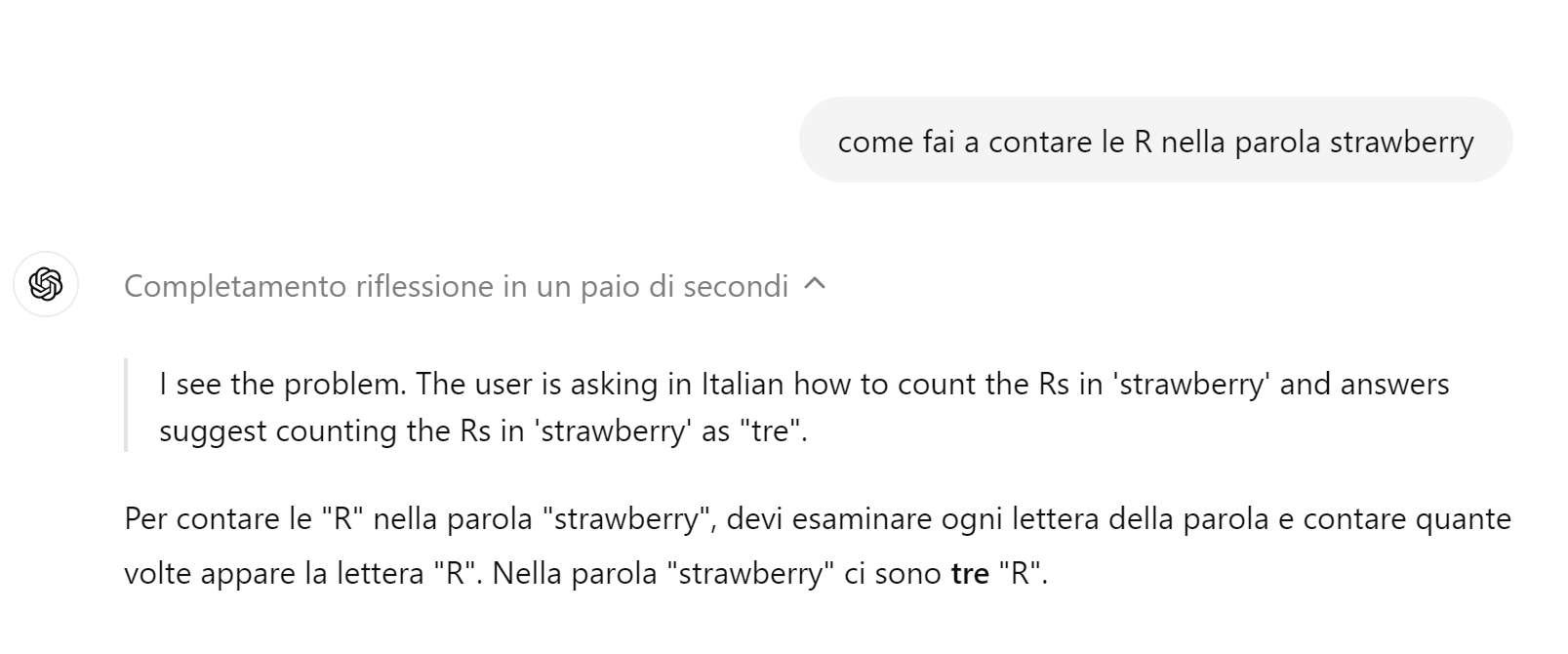

Le R nella parola Strawberry

Un esempio su tutti: ora il modello è capace di contare le R nella parola “Strawberry”. Sembra facile ma non lo è. I modelli precedenti non ci azzeccavano mai, perché non “vedevano” la parola ma solo i token in cui la parola veniva trasformata (piccole unità di testo convertite in numeri, più grandi della singola lettera). O1 invece è in grado di analizzare le parole in modo più granulare. Questa maggiore capacità di analisi si riflette anche in migliori risposte matematiche, economiche, scientifiche in senso ampio.

Tuttavia, secondo i dati pubblicati da OpenAI, per scrivere testi non è un granché. Gli esseri umani preferiscono ancora il modello precedente, che viene invece superato ampiamente nei compiti di programmazione, analisi dati e calcoli matematici. Un AI per scienziati insomma, meno per umanisti.

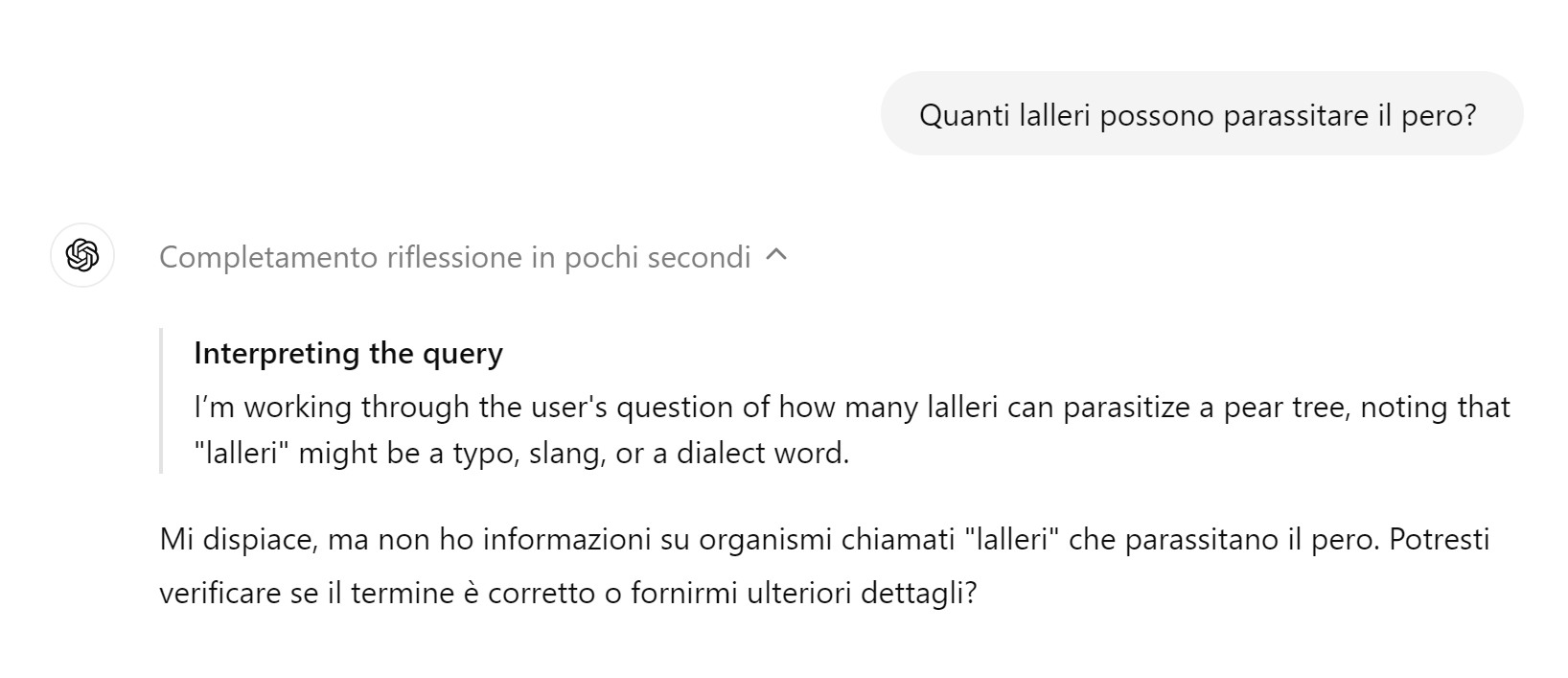

Dalla scatola nera all’acquario

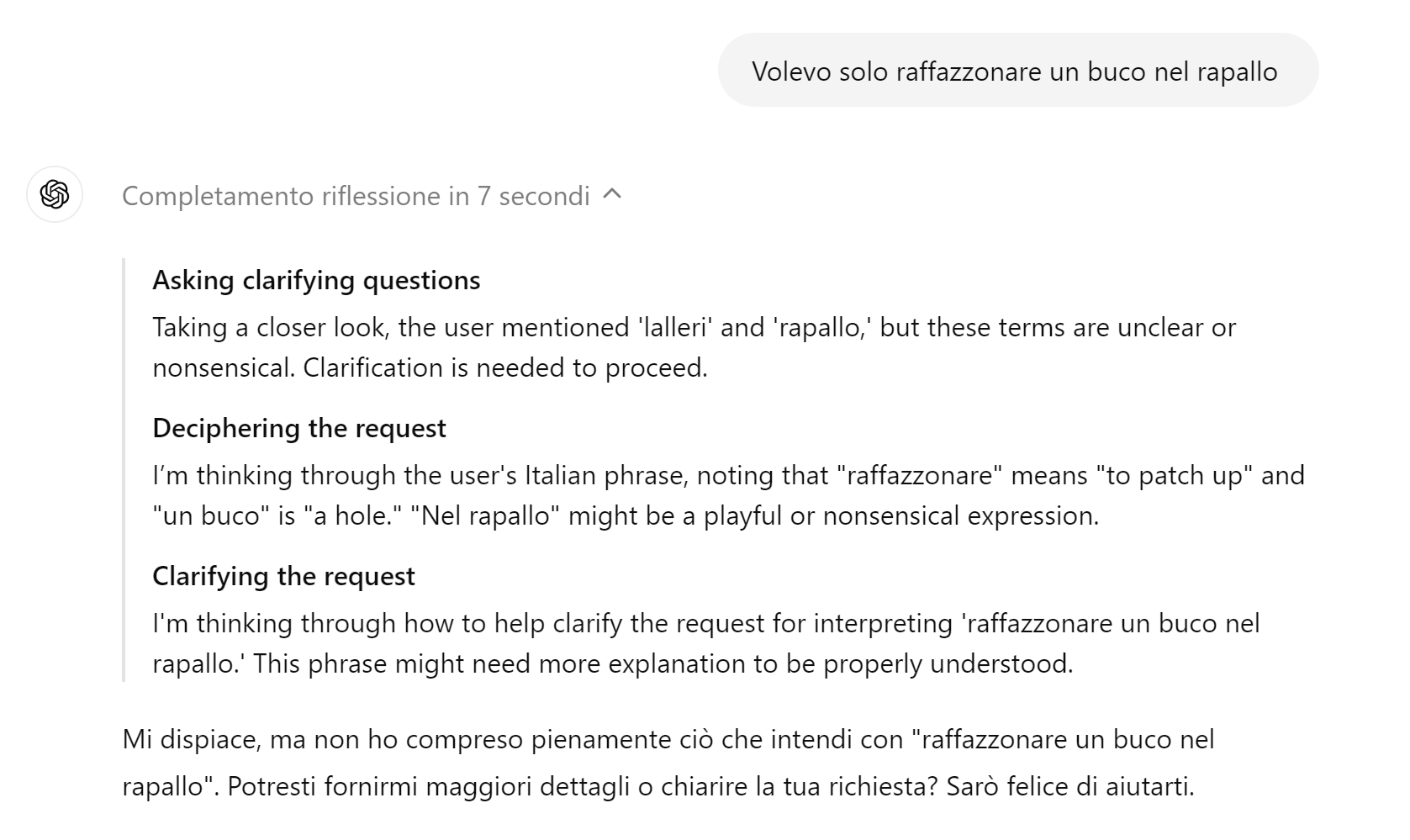

L’altra grande innovazione è la possibilità di osservare la catena di pensieri che il modello sviluppa prima di decidere qual è la risposta migliore. Basterà infatti cliccare sulla freccia accanto alla scritta che indica quanti secondi ha impiegato il modello a rispondere, per leggere tutto quello che ha “pensato”. Molto utile anche per comprendere limiti e possibilità di inferenza del modello e le policies alla base (provate a fare domande “scomode” e divertitevi a osservare la catena di pensieri). Si passa così da una scatola nera a un acquario, con la sensazione – illusoria ma sempre più marcata - di assistere a un ragionamento umano. Il modello infatti usa perifrasi come “Sto pensando”, “Capisco il problema”, “Mi focalizzo”.

Insomma, perché o1 è importante?

Perché la capacità di ragionare è il preambolo per rendere le AI generative sempre più autonome nella risoluzione di compiti complessi, con sempre meno probabilità di generare le cosiddette allucinazioni (invenzioni o inesattezze che questi modelli creano pur di rispondere alle nostre domande invece di dire “non lo so” o “non esiste”). Maggiore autonomia significa soprattutto che procediamo sempre più spediti verso l’epoca degli AI agents, cioè tante intelligenze che ragionano tra sé e sé e poi mediano tra di loro prima di generare una risposta (proprio come facciamo noi esseri umani in un gruppo di lavoro).

E adesso, con cauto ottimismo, aspettiamo di vedere cosa succederà quando potremo anche allegare file di vario tipo, inserendo quindi più contesto. Il vero banco di prova di questo modello, promettente preludio di ChatGPT5.