Meta ha recentemente introdotto sul mercato l'ultima innovazione della sua serie di modelli di intelligenza artificiale generativa aperti, il Llama 3. Questo rilascio include due varianti, Llama 3 8B con 8 miliardi di parametri e Llama 3 70B con 70 miliardi di parametri, descritte come un significativo passo avanti rispetto ai precedenti modelli della serie, Llama 2.

I parametri, che definiscono la capacità di un modello IA di affrontare specifici problemi come l'analisi e la generazione di testi, sono indicativi della maggiore abilità dei nuovi modelli, particolarmente addestrati su due cluster GPU costruiti su misura, ciascuno con 24.000 unità. Meta sostiene che, per il numero di parametri, questi modelli rappresentano alcuni tra i migliori modelli di IA generativa attualmente disponibili.

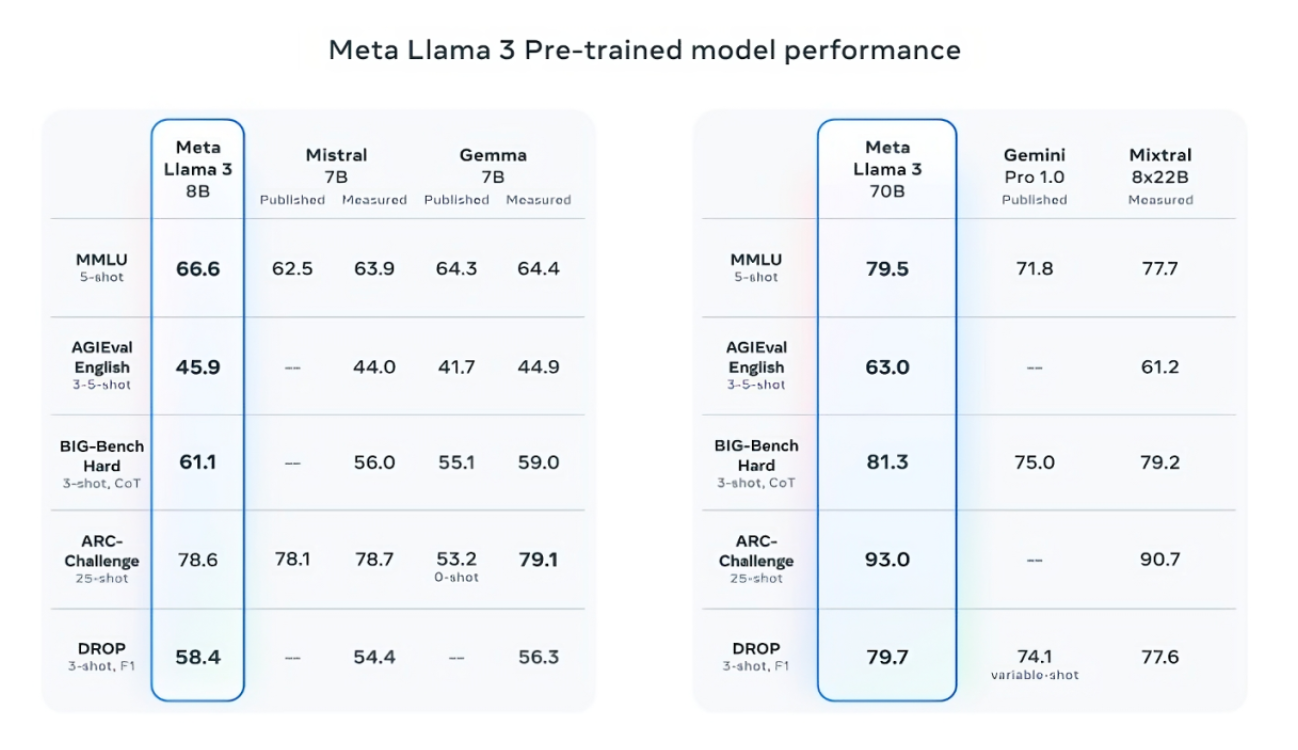

Meta supporta queste affermazioni facendo riferimento ai punteggi ottenuti dai modelli Llama 3 in diversi benchmark di intelligenza artificiale riconosciuti, come MMLU, ARC e DROP, che misurano rispettivamente la conoscenza, l'acquisizione di competenze e la capacità di ragionamento sui testi. Nonostante l'utilità e la validità di questi benchmark possano essere discutibili, rimangono tra i pochi metodi standardizzati utilizzati dalle aziende del settore per valutare i propri modelli.

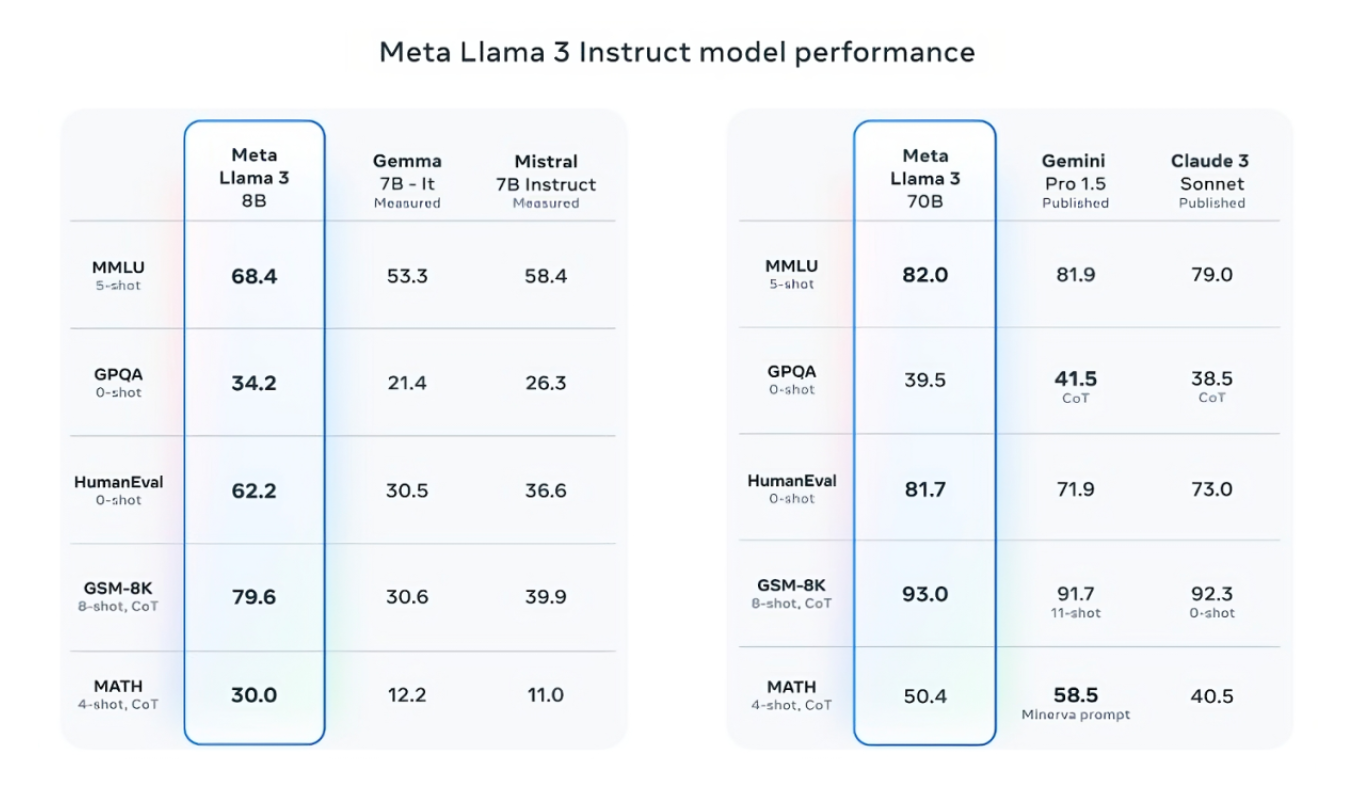

In particolare, il modello Llama 3 8B ha superato altri modelli aperti in almeno nove benchmark, tra cui spiccano MMLU, ARC, DROP e HumanEval, un test di generazione di codice. Anche il modello più capiente, Llama 3 70B, si è dimostrato competitivo, superando modelli di punta come il Gemini 1.5 Pro di Google in diverse valutazioni e mostrando prestazioni superiori rispetto ad altri modelli meno performanti della serie Claude 3 di Anthropic.

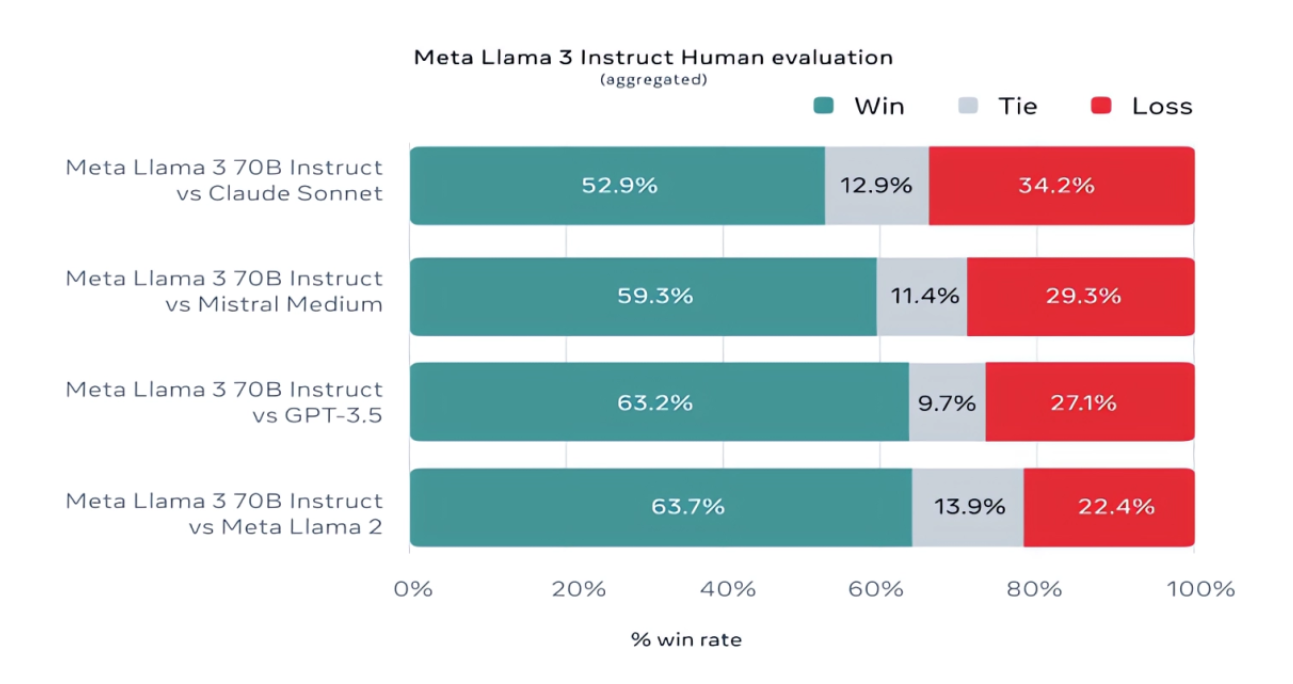

Meta ha inoltre sviluppato un proprio insieme di test per coprire una vasta gamma di casi d'uso, che vanno dalla programmazione alla scrittura creativa, dal ragionamento alla sintesi, con il modello Llama 3 70B che ha ottenuto i migliori risultati. Tuttavia, la credibilità di questi risultati può essere messa in discussione, dato che il test è stato ideato dalla stessa Meta, che ha anche impedito ai propri team di modellazione di accedere al set di test per mantenere l'obiettività.

Al di là dei numeri, Meta promette che i nuovi modelli Llama offriranno maggiore "manovrabilità", una minor probabilità di rifiutare di rispondere a domande e un'accuratezza superiore in domande di trivia e in campi come la storia e le STEM. Questi miglioramenti sono il risultato di un insieme di dati notevolmente ampliato, che comprende 15 trilioni di token, sette volte la dimensione del set di addestramento di Llama 2. Meta non ha specificato la provenienza esatta di questi dati, se non che includono fonti pubblicamente disponibili e una percentuale di dati non in inglese per migliorare le prestazioni in altre lingue.

Per quanto riguarda la sicurezza, Meta ha sviluppato nuovi processi di filtraggio dei dati per migliorare la qualità del training dei modelli e ha aggiornato i suoi strumenti di sicurezza generativa IA, Llama Guard e CybersecEval, per prevenire l'uso improprio e la generazione di testi indesiderati. Nonostante queste misure, i problemi come la tossicità e i bias rimangono una sfida continua.

I modelli Llama 3, ora disponibili per il download e integrati nell'assistente IA di Meta su piattaforme come Facebook, Instagram, WhatsApp, Messenger e il web, saranno presto ospitati su una varietà di piattaforme cloud. Inoltre, sono previste versioni dei modelli ottimizzate per hardware di vari produttori.